Lernen: Unterschied zwischen den Versionen

Wehner (Diskussion | Beiträge) (Die Seite wurde neu angelegt: „{{Nav|Navigation|Kognitive Modellierung|Hauptseite}} Artikelinhalt“) |

Elisa (Diskussion | Beiträge) Keine Bearbeitungszusammenfassung |

||

| (9 dazwischenliegende Versionen von 2 Benutzern werden nicht angezeigt) | |||

| Zeile 1: | Zeile 1: | ||

{{Nav|Navigation|Kognitive Modellierung|Hauptseite}} | {{Nav|Navigation|Neuronale Netze|Kognitive Modellierung|Hauptseite}} | ||

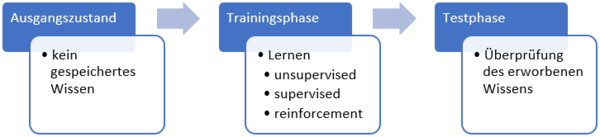

Die Verbindungsgewichte zwischen Neuronen bzw. Knoten bilden das „Gedächtnis“ [[Neuronale Netze|neuronaler Netze]]. In ihnen ist das Wissen gespeichert, welches das [[Neuronale Netze|neuronale Netz]] während seiner Verarbeitung von Input-Information (der Trainingsphase) erworben hat. Zu Beginn werden die Gewichte üblicherweise zufällig gewählt oder alle mit Null beziehungsweise einem anderen Fixwert initialisiert. Darauf folgt die Trainingsphase, in welcher dem [[Neuronale Netze|neuronalen Netz]] ein Set an Inputmustern dargeboten wird. Die Aktivierung der Inputneuronen breitet sich im Netzwerk aus und regt eine Modifikation der Verbindungsgewichte an (=> Lernen). Das grundlegende Prinzip der Gewichtsveränderung stammt von Hebb (1949): „What fires together, wires together“. Damit wird ausgedrückt, dass die Verbindung zwischen zwei gemeinsam aktivierten Neuronen stärker wird. | |||

Im Grunde lassen sich drei Arten von Lernregeln unterscheiden: | |||

* Das klassische [[Unsupervised: Hebb|Hebb’sche Lernen]] wird als '''unsupervised''' oder '''selbstorganisiertes''' Lernen bezeichnet, da es keine Vorgabe gibt, wie der Output aussehen soll. Die Gewichtsveränderungen erfolgen in Abhängigkeit der Ähnlichkeit der Gewichte mit den Inputs bzw. Outputs. | |||

* Beim '''[[Supervised|supervised]]''' beziehungsweise '''error-driven''' Lernen ist das Endergebnis bekannt und die Gewichtsanpassung erfolgt in Abhängigkeit der Abweichung vom Zielmuster (teaching output). | |||

* Eine weitere Form ist das '''[[Reinforcement]]-''' oder '''Verstärkungslernen''', bei dem kein Output vorgegeben wird, sondern nur eine Rückmeldung darüber, ob der vom Netz erzeugte Output korrekt ist oder nicht. | |||

Wenn die Trainingsphase beendet ist, kann eine Testphase angeschlossen werden, die Auskunft darüber gibt, was und wie viel das [[Neuronale Netze|neuronale Netz]] gelernt hat. Dazu werden erneut Inputmuster präsentiert, jedoch ohne anschließende Veränderung der Gewichte. Es wird lediglich beobachtet, welchen Output das Netzwerk berechnet und mit dem korrekten Output abgeglichen. Neben der erneuten Präsentation der Ausgangsmuster ist es möglich, neue Inputmuster einzuführen, um die Generalisierungsfähigkeit des Netzes zu überprüfen. | |||

[[Datei:Lernen.PNG|600px|link=Ausgelagerte_Bildbeschreibungen#Lernen|Ausgelagerte Bildbeschreibung von Lernen]] | |||

[[Datei:Simulationslink_neu2.PNG|link=http://141.76.19.82:3838/mediawiki/NeuroNetz/ | |||

|120px]] <span style="color: white"> kkk </span> Ein einfaches Beispiel für das Lernen in künstlichen neuronalen Netzen kann in der R-Shiny-App [http://141.76.19.82:3838/mediawiki/NeuroNetz/ "Neuronale Netze"] beobachtet und untersucht werden. | |||

Aktuelle Version vom 28. November 2021, 20:01 Uhr

Die Verbindungsgewichte zwischen Neuronen bzw. Knoten bilden das „Gedächtnis“ neuronaler Netze. In ihnen ist das Wissen gespeichert, welches das neuronale Netz während seiner Verarbeitung von Input-Information (der Trainingsphase) erworben hat. Zu Beginn werden die Gewichte üblicherweise zufällig gewählt oder alle mit Null beziehungsweise einem anderen Fixwert initialisiert. Darauf folgt die Trainingsphase, in welcher dem neuronalen Netz ein Set an Inputmustern dargeboten wird. Die Aktivierung der Inputneuronen breitet sich im Netzwerk aus und regt eine Modifikation der Verbindungsgewichte an (=> Lernen). Das grundlegende Prinzip der Gewichtsveränderung stammt von Hebb (1949): „What fires together, wires together“. Damit wird ausgedrückt, dass die Verbindung zwischen zwei gemeinsam aktivierten Neuronen stärker wird.

Im Grunde lassen sich drei Arten von Lernregeln unterscheiden:

- Das klassische Hebb’sche Lernen wird als unsupervised oder selbstorganisiertes Lernen bezeichnet, da es keine Vorgabe gibt, wie der Output aussehen soll. Die Gewichtsveränderungen erfolgen in Abhängigkeit der Ähnlichkeit der Gewichte mit den Inputs bzw. Outputs.

- Beim supervised beziehungsweise error-driven Lernen ist das Endergebnis bekannt und die Gewichtsanpassung erfolgt in Abhängigkeit der Abweichung vom Zielmuster (teaching output).

- Eine weitere Form ist das Reinforcement- oder Verstärkungslernen, bei dem kein Output vorgegeben wird, sondern nur eine Rückmeldung darüber, ob der vom Netz erzeugte Output korrekt ist oder nicht.

Wenn die Trainingsphase beendet ist, kann eine Testphase angeschlossen werden, die Auskunft darüber gibt, was und wie viel das neuronale Netz gelernt hat. Dazu werden erneut Inputmuster präsentiert, jedoch ohne anschließende Veränderung der Gewichte. Es wird lediglich beobachtet, welchen Output das Netzwerk berechnet und mit dem korrekten Output abgeglichen. Neben der erneuten Präsentation der Ausgangsmuster ist es möglich, neue Inputmuster einzuführen, um die Generalisierungsfähigkeit des Netzes zu überprüfen.

kkk Ein einfaches Beispiel für das Lernen in künstlichen neuronalen Netzen kann in der R-Shiny-App "Neuronale Netze" beobachtet und untersucht werden.