Neuronale Netzwerke

Neuronale Netzwerke

Die Idee der Modellierung psychischer Prozesse durch Künstliche Neuronale Netze entspricht der Forschungsrichtung des Konnektionismus. Die Idee dahinter ist, Modelle einzelner Komponenten in Anlehung an die Funktionsweise des Gehirns zu entwerfen. Diese Komponenten spiegeln Prozesse der Informationsverarbeitung wider und können diese auf gegebenen Stimuli ausführen. Die zentralen Fähigkeiten neuronaler Netze liegen im Lernen und der Selbstorganisation von Informationen, der damit verbundenen Toleranz von Informationsfehlern, dem Erkennen von Mustern und schließlich der Generalisierung dieser Prozesse, z.B. auf noch nie gesehene Stimuli.

Durch die Modellierung sollen Verhaltensweisen und Verhaltensveränderungen repliziert, erklärt und vorhergesagt werden.

Grundlagen

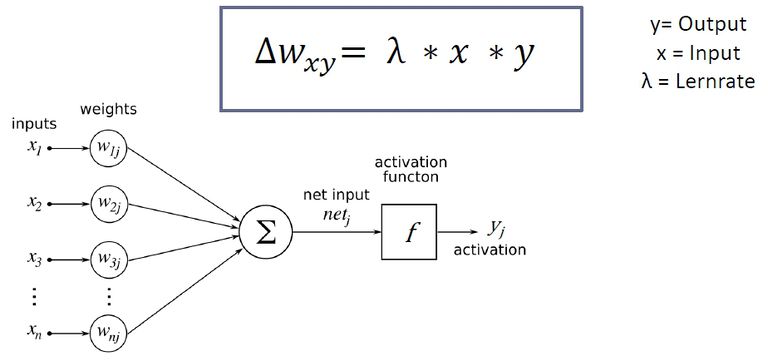

Bei der Modellierung durch Künstliche Neuronale Netze greift man unter anderem auf die {Neuronenhypothese} zurück, es werden Neurone „simuliert“. Hierbei werden kleinste einfache Einheiten verschaltet. Diese Verschaltungen ähneln biologischen „Synapsen“', also den Verbindungsstellen zwischen biologischen Neuronen. Aufgrund dieser Verbindungen erhält jede Einheit vektorielle Inputs („Reize“) von ihren verbundenen Nachbareinheiten. Diese Reize werden je nach Verbindungsstärke unterschiedlich gewichtet. Die Gewichtung des Inputs ist dabei im Modell veränderbar, was die Basis für späteres Lernen bildet. Diese gewichteten Inputs werden im in der Einheit (auch „Unit“ oder „Knoten“ genannt) aufsummiert (kumuliert). Über eine Aktivierungsfunktion wird schließlich der Output berechnet. Er ist skalar (durch einen numerischen Wert beschrieben) und oftmals nichtlinear (abhängig von der gewählten Aktivierungsfunktion).

Lernen findet durch Veränderung der Verbindungsstärken zwischen Einheiten statt. Donald O. Hebb entwarf 1949 die grundlegende Lernregel: „what fires together, wires together“. Die Idee ist, dass gleichzeitig feuernde Neurone stärker miteinander verknüpft werden. Seine Formel kann in Künstlichen Neuronalen Netzen z.B. eingesetzt werden um die Konditionierung zu simulieren: ein US (z.B. Essen im Mund) und ein CS (z.B. Glockenleuten) aktivieren jeweils eine Einheit. Diese Einheiten wiederum sind mit einer weiteren Einheit (z.B. Speicheln) verbunden. Wenn nun die US Einheit aktiviert ist (Essen im Mund), aktiviert das die Verhaltenseinheit (Speicheln). Wenn nun gleichzeitig die CS Einheit aktiviert wird (Glocke läutet), so führt die Koaktivierung der Einheiten zu einer Verstärkung der Verbindungsgewichte zwischen ihnen. Mit der Zeit genügt der CS, um das Verhalten auszulösen.

Funktionale Unterschiede

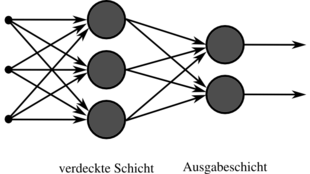

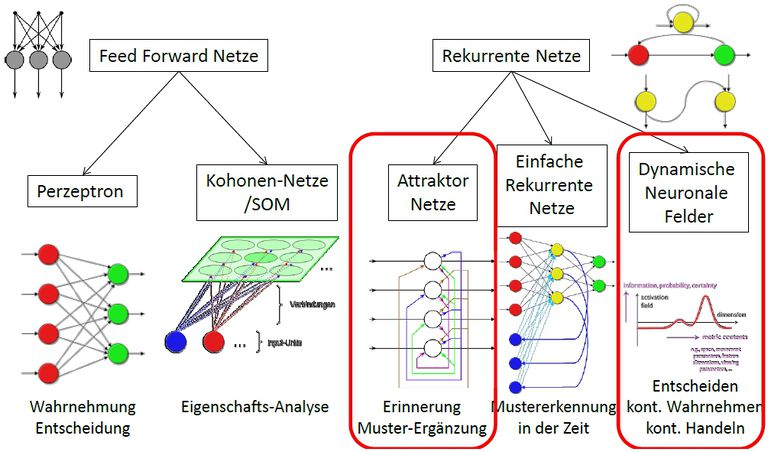

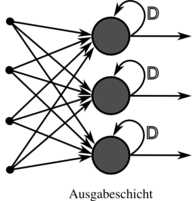

Künstliche Neuronale Netze unterscheiden sich in ihren Funktionen vor allem durch ihre Struktur. Es gibt einschichtige und mehrschichtige Netze. Einschichtige neuronale Netze bestehen aus nur einer Schicht Neuronen, mehrschichtige aus mehreren Schichten. Letztere können wiederrum entweder feedforward oder rekurrente (feedback) vernetzt sein. Bei mehrschichtigen Netzten nennt sich die Eingabeschicht „input layer“, die Ausgabeschicht „output layer“, dazwischenliegende verdeckte Schichten heißen „hidden layers“. Ein feedforward Netz bedeutet, dass eine Schicht immer nur mit der nächsthöheren verbunden ist, während rekurrente Netze über Rückkopplungsverbindungen verknüpft sind. Sie erlauben somit ein Feedback zu der Information, welches ein dynamisches Verhalten des Netzwerkes möglich macht.

einschichtig, feedforward

mehrschichtig, feedforward

einschichtig, rekurrent

Bilder CC-BY-SA 3.0 by Chrislb

Komplexe Netzwerkarchitekturen

Um die komplexen Mechanismen eines Gehirns zu modellieren, die zum Beispiel bei sozialer Interaktion auftreten, genügt die Simulation durch ein Netz oft nicht. Man koppelt dann zum Beispiel mehrere verschiedene künstliche neuronale Netze hierarchisch aneinander und setzt so ein komplexes neuronales Netz aus mehreren einfacheren Subnetzen zusammen.