Reliabilität

Die Reliabilität gibt die Zuverlässigkeit und Beständigkeit einer Untersuchung an und bezieht sich auf den Grad der Messgenauigkeit eines Messverfahrens. Je reliabler ein Messinstrument ist, desto häufiger wird es bei mehrfachen Messungen das (exakt) gleiche Messergebnis anzeigen.

Auf die klassische Testtheorie bezogen, richtet sich die Frage also nach der Größe des Fehlers E.

Man unterscheidet in der Anwendung vier Arten von Reliabilität:

Retestreliabilität

Die Retestreliabilität gibt die Zuverlässigkeit der Daten bei mehrfacher Durchführung des gleichen Tests zu unterschiedlichen Zeitpunkten an.

Die Daten einer Messung werden mit den Daten einer folgenden Messung an derselben Stichprobe korreliert. Das heißt, es wird der Grad des Zusammenhangs berechnet. .

Ab einem Wert von r > (+/-) 0.8 spricht man von einer guten Reliabilität, hohe Reliabilität liegt ab einem Wert von r> (+/-) 0.9 vor. .

Bei der Retestreliabilität können Probleme auftreten. So kann es zum Beispiel sein, dass sich eine Versuchsperson bei einer zweiten Messung an Items erinnert oder "dazugelernt" hat (siehe Within Subjects Design).

Außerdem steckt hinter der Retestreliabilität die Annahme, dass man ein unveränderliches Merkmal erfasst. Wenn man nun aber in Betracht zieht, dass sich das Merkmal doch zeitlich verändern kann (z.B. Zufriedenheit mit steigendem beruflichem Erfolg), kann eine geringe Retestreliabilität entweder auf eine geringe Testreliabilität oder auf die Zeitabhängigkeit bzw. Instabilität des Merkmals zurückgeführt werden und ist damit nicht eindeutig. Weitere Probleme äußern sich im zeitlichen Aufwand sowie der zu wahrenden Anonymität der Versuchspersonen.

Paralleltestreliabilität

Um Reliabilität mit der Paralleltestmethode zu prüfen, bearbeiten Versuchspersonen eine Aufgabe, die mit zwei verschiedenen Messinstrumenten analysiert wird. Diese erheben entweder gleichzeitig (ein Beobachter schätzt die Nervosität der Versuchsperson ein, während die Hautleitfähigkeit (EDA) gleichzeitig das Arousal misst) oder gleichzeitig, bzw. kurz hintereinander (zwei Tests mit minimaler Verzögerung). Die Daten, die aus der Erhebung mit den beiden Messinstrumenten hervorgehen, werden über die Gesamtheit der Probanden miteinander korreliert. Gleichen sich die Ergebnisse der beiden parallelen Erhebungen, so kann man davon ausgehen, dass die Erhebungsmethoden beide reliabel und zuverlässig sind. Unterscheiden sich die Ergebnisse voneinander, muss man ebenfalls beide Instrumente vorerst als unreliabel verwerfen, da man nicht herausfinden kann, welches der Messinstrumente womöglich eigentlich zuverlässige Daten lieferte.

Bei der Erhebungsmethode der Beobachtung spricht man spezifischer von der Inter-Rater-Reliabilität, wenn mehrere Beobachter das gleiche Ergebnis finden.

Schwierigkeiten der Paralleltestmethode sind möglicherweise das Finden oder Erstellen zweier äquivalenter Messmethoden (z.B. die Konstruktion zweier äquivalenter Tests), als auch der damit verbundene Zeitaufwand.

Interne Konsistenz

Bei der Methode der internen Konsistenz erfolgt die Reliabilitätsmessung innerhalb eines Tests. Anders als bei der Methode der Split-half Reliabilität werden hier allerdings nicht ganze Test-Partien miteinander verglichen – vielmehr wird die mittlere Korrelation aller einzelnen Items miteinander untersucht. Diese mittlere Korrelation wird durch den Koeffizienten α (Cronbachs Alpha) ausgedrückt. Je größer α (0 - 1), desto höher wird die Reliabilität (unter den in der Messung gegebenen Bedingungen!)

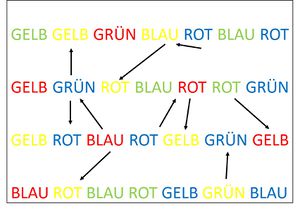

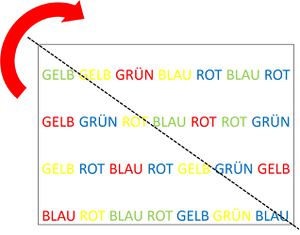

Interne Konsistenz, gemessen im Stroop-Task. Die Reaktionszeiten der einzelnen Items (Wörter) werden miteinander korreliert. Ist die Korrelation hoch, so messen die einzelnen Wörter zuverlässig das interessierende Merkmal (kognitive Kontrolle).

Problem:

Möglicherweise entsteht ein hohes α lediglich aus dem Grund, dass die Items sich sehr stark ähneln und dennoch bei wiederholten Messungen andere Ergebnisse liefern würden. Dadurch wäre die Reliabilität nicht mehr gewährleistet. Je mehr Items verwendet werden, desto zuverlässiger ist die Methode der internen Konsistenz.

Beispiel: Folgende zwei Items wollen die Qualität einer Freundschaft (Skala von 1 bis 10) abfragen (eigentlich bräuchte man viel mehr Items!):

(1) Ich treffe meine Freunde regelmäßig

(2) Ich habe regelmäßigen Kontakt zu meinen Freunden

Fraglich ist, ob die Qualität einer (als konstant angenommenen) Freundschaft durch diese Fragen zuverlässig in mehreren Messwiederholungen abgefragt werden kann. Das Problem liegt in der Unklarheit des Wortes "regelmäßig". So könnte eine Versuchsperson in einem Erhebungsdurchgang den monatlichen Kontakt zu ihrer besten Freundin als "regelmäßig" empfinden, im nächsten Durchgang aber vielleicht nicht (monatlich ist zu selten, um es als regelmäßig zu bezeichnen etc.). Trotzdem würde Sie die Fragen (1) und (2) vermutlich ähnlich bewerten, da sie etwas sehr ähnliches abfragen. Die Korrelation zwischen den beiden Items - Cronbachs Alpha- wäre dementsprechend hoch, würde aber keine Reliabilität (geschweige denn Validität oder Objektivität) nachweisen, sondern lediglich Item-Ähnlichkeit bzw. {Homogenität} der Skala (siehe auch Itemanalyse bei der {Skalenkonstruktion}).

Bei hoher Korrelation der folgenden Items würde man eher von Reliabilität des Tests ausgehen können:

(1) Ich treffe mich gerne mit meinen engsten Freunden

(2) Ich vertraue meinen Freunden sehr

Die beiden Items fragen unterschiedliche Indikatoren für die Qualität der Freundschaft ab (Kontakt,Vertrauen). Die hohe Korrelation aufgrund von Item-Ähnlichkeit könnte daher ausgeschlossen werden und die Annahme einer Paralleltestreliabilität befürworten.

Split-half Reliabilität

Um die Reliabilität mittels der Testhalbierungsreliabilität (auch Split-half Reliabilität genannt) zu bestimmen, wird ein Test in zwei Hälften geteilt, welche dann miteinander korreliert werden. Die Idee hinter dieser Reliabilitätsbestimmung ist, dass ein Test, der ein bestimmtes Merkmal erfassen soll, dies konsistent über den gesamten Test und mit jedem Item tut. Die Items, die in der einen Hälfte des Tests zusammengefasst werden, und die andere Hälfte sollten sich daher in den Ergebnissen bezüglich einer vorhandenen Merkmalsausprägung nicht oder kaum unterscheiden. Ist dies dennoch der Fall, scheint der Test in sich nicht konsistent das gleiche Merkmal abzufragen.

Das Erstellen zweier äquivalenter Tests wie bei der Paralleltestreliabilität wird hier umgangen, allerdings können auch bei der Bestimmung der Split-half Reliabilität Schwierigkeiten auftreten. Zum einen stellt sich die Frage, wie die sinnvolle Aufteilung in zwei Hälften vorzunehmen ist und wie man berücksichtigt, dass sich (trotz hoher Reliabilität der einzelnen Test-Partien) die Ergebnisse im Test z.B. durch Übung verändern können (Versuchsperson wird bspw. schneller aus reinem Gewöhnungs- oder Übungseffekt).