Aufgaben der Modellierung

Viele Dinge, die wir in unserer Umwelt erleben, sind schwierig zu verstehen. Warum zeigt eine Kerzenflamme immer nach oben? Wie kann ein großer Raubvogel so lange in der Luft treiben, ohne die ganze Zeit mit seinen Flügeln schlagen zu müssen? Auch viele Dinge, die wir selbst tun, scheinen uns unerklärlich. Wie kann es sein, dass wir manchmal so viel Ungesundes essen oder in Diskussionen aggressiv werden, obwohl wir wissen, dass es uns später ernsthaft schaden wird? Spontane Erklärungsversuche scheitern häufig an der Komplexität der betrachteten Phänomene. Um mit dieser Komplexität umzugehen, die darunterliegenden Prozesse besser zu verstehen und damit diejenigen Fragen zu beantworten, die uns Menschen beschäftigen, entwerfen Wissenschaftler Theorien und damit (mindestens verbale) Modelle.

Laut Dörner (1994) ist ein Modell „eine Replikation eines Realitätsausschnitts, sein Abbild.“ Ein reales System (Urbild) wird demnach durch die Fokussierung auf wesentliche Merkmale und Relationen vereinfacht als Modell (Abbild) dargestellt. Die Trennung von Wesentlichem und Unwesentlichem (unwichtige Details) ist ein zentraler Schritt der Modellbildung und führt zur Reduktion von Komplexität. Diese Trennung ist abhängig vom jeweiligen Erkenntnisinteresse, also welche Fragen durch das Modell beantwortet werden sollen.

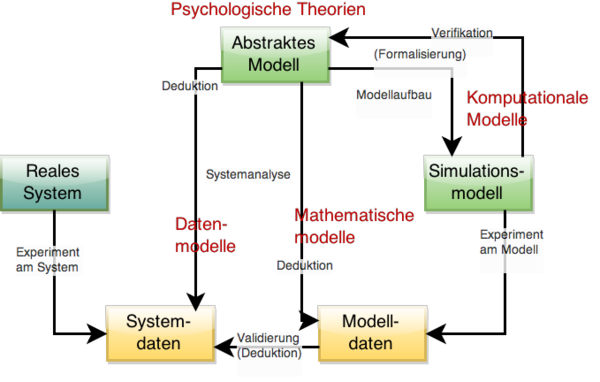

Die folgende Abbildung veranschaulicht den Prozess der Modellierung:

Ausgangspunkt jeder empirischen Wissenschaft und damit auch der Psychologie und ihrer Modelle ist eine reale Situation oder ein reales System, das eine Frage aufwirft. Geht man induktiv an den Prozess heran, muss man das System in den Blick nehmen und Informationen (Daten) darüber sammeln, entweder durch Beobachtung oder im Rahmen eines Experiments. Aus der Analyse dieser Systemdaten kann man anschließend ein Modell entwickeln, welches das System am besten beschreibt. Hat man ein solches Modell, kann man aus ihm wiederum Schlussfolgerungen auf zu erwartende Daten ziehen (Deduktion) und so das Modell prüfen. In der Psychologie ist dies der normale Forschungsprozess und das gebildete abstrakte Modell entspricht in der Regel einer verbalen Theorie.

Der Prozess der Formalisierung besteht nun darin, aus dem abstrakten Modell ein formales Modell, und damit meistens ein Simulationsmodell abzuleiten. Um diese Modellbildung zu vollziehen, ist eine Strukturierung und Idealisierung des Systems notwendig. Ein Simulationsmodell erlaubt es dann in Computersimulationen Daten zu generieren, also Hypothesen über erwartetes Verhalten des echten Systems abzuleiten und diese dann zu vergleichen. Im Gegensatz zu verbalen Vorhersagen können diese generierten Daten u.U. eine höhere Präzision aufweisen. Durch den Vergleich der simulierten Modelldaten und der empirisch erhobenen Systemdaten können Rückschlüsse auf die Validität (= Gültigkeit) der entwickelten Modelle getroffen werden. Das Simulationsmodell kann aber auch genutzt werden, um die innere Schlüssigkeit der abstrakten Modellannahmen zu verifizieren oder zu falsifizieren (proof-of-concept).

Je nach Ergebnis der Validierung durch den Vergleich von Modelldaten und echten Daten oder durch den proof-of-concept müssen ggf. die Annahmen des abstrakten Modells oder des Simulationsmodells verbessert werden. Das daraus resultierende aktualisierte Modell wird im Anschluss erneut validiert. Dieser kreislaufartige Prozess wird so lange durchlaufen, bis er ein zufriedenstellendes Ergebnis liefert.

Erkenntnisziel der Modellierung

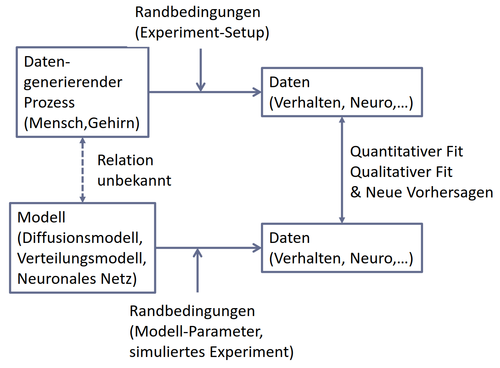

Modelle sollen reale Systeme vereinfacht abbilden. Die genaue Relation des Modells zum realen System ist dabei zunächst unbekannt, d.h. wir wissen nicht ohne weiteres, ob unser Modell ein gutes Abbild darstellt. Um diese Frage zu lösen, hilft es, das Realsystem (z.B. ein sich verhaltender Mensch oder ein Gehirn) als einen uns unbekannten datengenerierenden Prozess zu verstehen – eine Blackbox sozusagen, in die wir nicht hineinsehen können. Dieser Prozess erzeugt Daten (Verhalten, neuronale Aktivität) bzw. wir messen Daten, die die Blackbox hervorbringt. Da wir Daten nicht im leeren Raum messen, erhalten wir die relevanten Informationen aus dem datengenerierenden Prozess immer unter bestimmten Randbedingungen, z.B. einem kontrollierten experimentellen Setup.

Wenn wir nun zu einem inneren Verständnis des datengenerierenden Prozesses kommen wollen, können wir ein Modell erstellen, welches selbst über bestimmte Randbedingungen (Festlegung von Modell-Parametern, simulierte Aufgabe/Experiment) Daten generiert (simuliertes Verhalten, simulierte neuronale Aktivität). Diese simulierten Daten können wir dann mit den Daten des echten, uns unbekannten Prozesses vergleichen, sei es qualitativ - über bestimmte Verhaltensmuster - oder quantitativ - über den sogenannten Fit. Durch diesen Vergleich können wir Rückschlüsse darauf ziehen, ob zwischen datengenierendem Prozess und Modell eine gültige Modellrelation besteht – das Modell also den Prozess angemessen abbildet. Über weitere Variationen der Randbedingung und anschließende weitere Simulationen können uns Modelle sogar neuartige Ergebnisse liefern, die wir durch die Manipulation der Randbedingungen des datengenerierenden Prozesses an realen Daten überprüfen können. Modelle ermöglichen uns also, neue Vorhersagen aus simulierten Experimenten zu treffen und diese dann in realen Experimenten zu überprüfen.